Параметры URL-адреса могут быть кошмаром для SEO. Прочитайте, как с ними обращаться, чтобы улучшить сканирование и индексирование Google.

В мире SEO параметры URL составляют значительную проблему.

Хотя разработчики и аналитики данных могут оценить их полезность, эти строки запроса являются головной болью для SEO.

Бесчисленные комбинации параметров могут разделить одно намерение пользователя на тысячи вариантов URL. Это может привести к осложнениям для сканирования, индексирования, видимости и, в конце концов, привести к снижению трафика.

Проблема в том, что мы не можем просто пожелать им прочь, а это значит, что крайне важно научиться управлять параметрами URL-адресов удобным для SEO способом.

Для этого мы исследуем:

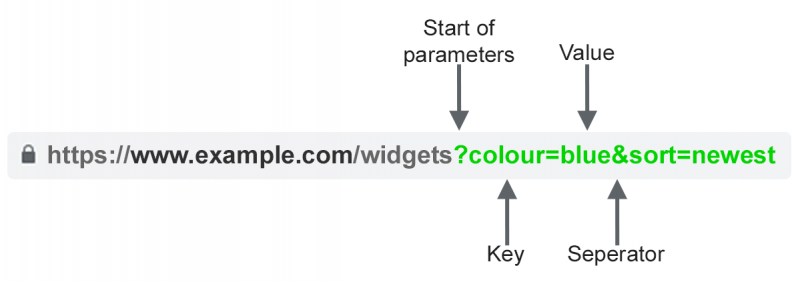

Что такое параметры URL?

Параметры URL-адреса, также известные как строки запроса или переменные URI, являются частью URL-адреса, следующего за ‘?’ символ. Они состоят из пары ключа и значения, разделенных ‘=’ знак. К одной странице можно добавить несколько параметров, разделенных &’.

Наиболее распространенными вариантами использования параметров являются:

- Отслеживание ∧; Например ?utm_medium=social, ?sessionid=123 или ? affiliateid =abc

- Изменение порядка – Например ?sort=самая низкая цена, ?заказ=высший рейтинг или ?да=последний

- Фильтрация – Например ?type=widget, colour=purple или ?price-range=20-50

- Идентификация &nd;; Например ?product=small-purple-widget, categoryid=124 или itemid= 24AU

- Пагинация– Например, ?page=2, ?p=2 или viewItems=10-30

- Поиск– Например, ?query=users-query, ?q=users-query или ?search=drop-down-option

- Перевод – Например, ?lang=fr или ?language=de

Проблемы SEO с параметрами URL

1. Параметры Создать дубликат содержимого

Часто параметры URL не делают существенных изменений в содержимом страницы.

Измененная версия страницы часто не так сильно отличается от оригинала. URL-адрес страницы с тегами отслеживания или идентификатор сеанса идентичен оригинала.

Например, все последующие URL-адреса вернут коллекцию виджетов.

- Статический URL: https://www.example.com/widgets

- Параметр отслеживанияr: https://www.example.com/widgets?sessionID=32764

- Параметр изменения порядка: https://www.example.com/widgets?sort=latest

- Идентификационный параметр: https://www.example.com?category=widgets< /b>

- Параметр поиска: https://www.example.com/products?search=widget

Это достаточно много URL для фактически того же содержимого – теперь представьте это каждой категории на вашем сайте. Это действительно может добавить.

Проблема заключается в том, что поисковые системы рассматривают каждый URL-адрес на основе параметров как новую страницу. Таким образом, они видят несколько вариантов той же страницы, все из которых содержат повторяющееся содержимое и все нацелены на ту же цель поиска или семантическую тему.

Хотя такое дублирование вряд ли повлечет за собой полную отфильтрацию веб-сайта из результатов поиска, оно приводит к каннибализации ключевых слов и может ухудшить представление Google об общем качестве вашего сайта, поскольку эти дополнительные URL-адреса не добавляют реальной ценности.

2. Параметры уменьшают эффективность обхода

Сканирование страниц с лишними параметрами отвлекает Googlebot, уменьшая способность вашего сайта индексировать страницы, релевантные SEO, и увеличивая нагрузку на сервер.

Google идеально суммирует это мнение.

“Чрезмерно сложные URL-адреса, особенно содержащие несколько параметров, могут создавать проблемы для сканеров, создавая чрезмерно большое количество URL-адресов, указывающих на идентичный или похожее содержимое на вашем сайт.

Как следствие, Googlebot может потреблять гораздо больше пропускной способности, чем нужно, или может быть не в состоянии полностью проиндексировать все содержимое на вашем сайте. 60~h3>3. Параметры Split Page Ranking Signals

Если у вас есть несколько изменений содержимого одной страницы, ссылки и публикации в социальных сетях могут появляться на разных версиях.

Это ослабляет ваши рейтинговые сигналы. Когда вы запутаете сканер, он становится неуверенным, какую из конкурирующих страниц индексировать для поискового запроса.

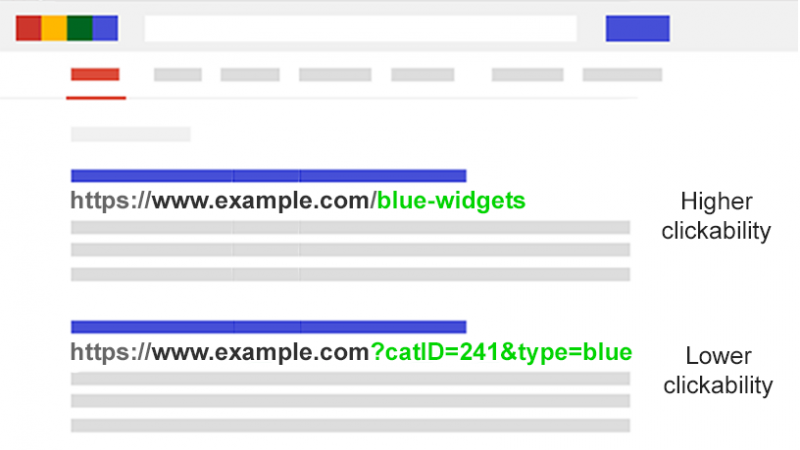

4. Параметры делают URL-адреса менее кликабельными

Изображение, созданное автором

Давайте правильно: URL-адреса параметров непривлекательны. Их тяжело читать. Похоже, они не заслуживают доверия. Таким образом, на них чуть меньше шансов нажать.

Это может повлиять на производительность страницы. Не только потому, что рейтинг кликов влияет на рейтинги, но и потому, что он менее активен в чат-ботах с искусственным интеллектом, в социальных сетях, электронных письмах, при копировании на форумах или где угодно, где может отображаться полная URL-. адрес.

Хотя это может лишь незначительно повлиять на расширение отдельной страницы, каждый твит, лайк, обмен, электронное письмо, ссылка и упоминание имеют значение для домена.

Плохая читабельность URL-адреса может способствовать снижению заинтересованности брендом.

Оцените степень вашей проблемы с параметрами

Важно знать каждый параметр, используемый на вашем веб-сайте. Но есть вероятность, что ваши разработчики не ведут актуальный список.

Так как найти все параметры, которые требуют обработки? Или понять, как поисковые системы сканируют и индексируют такие страницы? Узнать ценность, которую они приносят пользователям?

Выполните эти пять шагов:

- Запустите сканер: с помощью такого инструмента, как Screaming Frog, вы можете искать “?” в URL.

- Просмотрите файлы журнала: проверьте, сканирует ли Googlebot URL-адреса на основе параметров.

- Посмотрите отчет об индексации страницы Google Search Console: в образцах индекса и соответствующих неиндексированных исключений найдите ‘ ?’ в URL.

- Поиск на сайте: inurl: расширенные операторы: Узнайте, как Google индексирует параметры, которые вы нашли, указав ключ в запросе site:example. com inurl:key.

- Просмотрите отчет обо всех страницах в Google Analytics: найдите “?” чтобы увидеть, как каждый из найденных параметров используется пользователями. Убедитесь, что параметры URL-запроса не были исключены в настройках просмотра.

Вооружившись этими данными, теперь вы можете решить, как лучше обрабатывать каждый из параметров вашего веб-сайта.

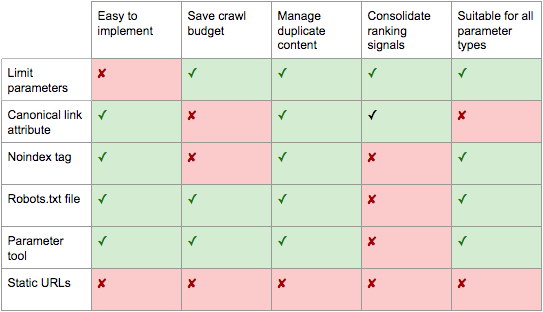

Решение SEO для укрощения параметров URL

В вашем арсенале SEO есть шесть инструментов для работы с параметрами URL на стратегическом уровне.

Ограничить URL-адреса на основе параметров

Простой обзор того, как и почему генерируются параметры, может обеспечить быструю победу в SEO.

Вы часто найдете способы уменьшить количество URL-адресов параметров и таким образом минимизировать негативное влияние на SEO. Есть четыре распространенных проблемы, с которых стоит начать обзор.

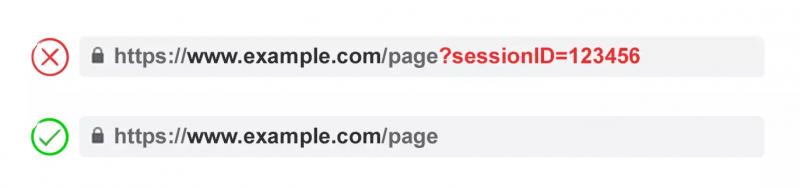

1. Устраните ненужные параметры

Изображение создано автором

Попросите разработчика предоставить список параметров каждого веб-сайта и их функций. Скорее всего, вы обнаружите параметры, которые больше не выполняют ценные функции.

Например, пользователей можно лучше идентифицировать с помощью файлов cookie, чем идентификаторов сессии. Однако параметр sessionID все еще может существовать на вашем веб-сайте, поскольку он использовался ранее.

Или вы можете обнаружить, что ваши пользователи редко применяют фильтр в вашей фасетной навигации.

Любые параметры, вызванные технической задолженностью, следует немедленно устранить.

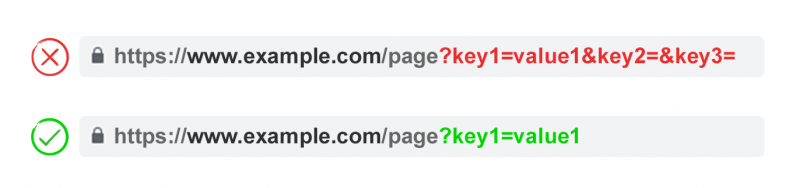

2. Предотвращать пустые значения

Избегайте нескольких параметров с одинаковым названием параметра и различными значениями.

Для параметров множественного выбора лучше комбинировать значения после одной клавиши.

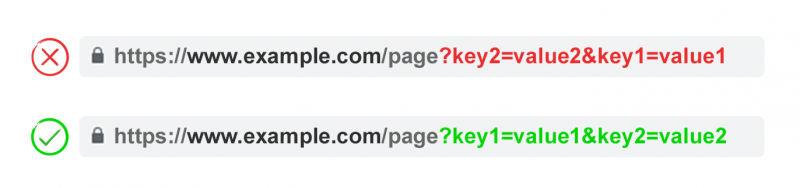

4. Параметры URL-адреса заказа

Изображение создано автором

Если тот же параметр URL-адреса изменяется, страницы интерпретируются поисковыми системами как одинаковые.

Как таковой порядок параметров не имеет значения с точки зрения повторяющегося содержимого. Но каждая из этих комбинаций тратит бюджет сканирования и распределяет рейтинговые сигналы.

Избегайте этих проблем, попросив своего разработчика написать сценарий, чтобы всегда размещать параметры в согласованном порядке, независимо от того, как их выбрал пользователь.

На мой взгляд, вы должны начать с любых параметров перевода, затем идентификация, затем разбивка на страницы, затем слойки на параметры фильтрации и изменения порядка или поиска, и, наконец, отслеживание.

<сильный>Плюсы:

- Обеспечивает более эффективное сканирование.

- Уменьшает проблему дублирования содержимого.

- Консолидирует сигналы рейтинга на меньшем количестве страниц.

- Подходит для всех типов параметров.

<сильный>Минусы:

- Умеренное время технической реализации.

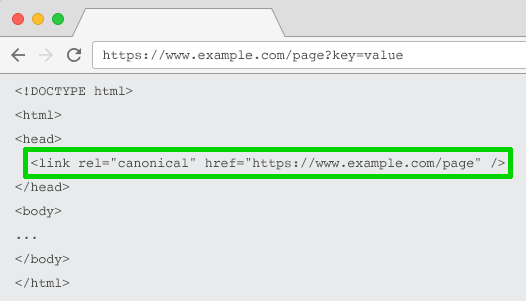

Rel=”Каноническое” Атрибут ссылки

Изображение, созданное автором

Поле rel=”канонический” атрибут ссылки указывает на то, что страница имеет идентичное или похожее содержимое другой. Это побуждает поисковые системы консолидировать сигналы ранжирования к URL-адресу, указанному как канонический.

Вы можете rel=canonical ваши URL-адреса на основе параметров к вашему SEO-дружественному URL-адресу для отслеживания, идентификации или изменения порядка параметров.

Но эта тактика непригодна, когда содержимое страницы параметров недостаточно близко к каноническому, например разбивка на страницы, поиск, перевод или некоторые параметры фильтрации.

<сильный>Плюсы:

- Относительно простая техническая реализация.

- Очень вероятно, что защитит от проблем с дублированием содержимого.

- Консолидирует сигналы ранжирования к каноническому URL-адресу.

<сильный>Минусы:

- Потеря ползания на страницах параметров.

- Не подходит для всех типов параметров.

- Интерпретируется поисковыми системами как сильная подсказка, а не директива.

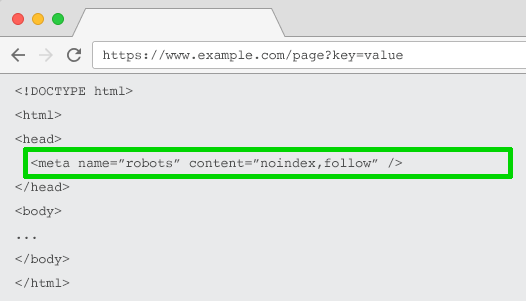

Noindex-тег Meta Robots

Изображение создано автором

Установите директиву noindex для любой страницы на основе параметров, которая не добавляет значения SEO. Этот тег не позволит поисковым системам индексировать страницу.

URL-адреса из “noindex” тег также, вероятно, будет сканироваться реже, и если он присутствует в течение длительного времени, это приведет к тому, что Google перестанет переходить по ссылкам страницы.

<сильный>Плюсы:

- Относительно простая техническая реализация.

- Очень вероятно, что защитит от проблем с дублированием содержимого.

- Подходит для всех типов параметров, которые вы не хотите индексировать.

- Удаляет существующие URL-адреса на основе параметров из индекса.

<сильный>Минусы:

- Не будет препятствовать поисковым системам сканировать URL-адреса, но будет побуждать их делать это реже.

- Не консолидирует рейтинговые сигналы.

- Интерпретируется поисковыми системами как сильная подсказка, а не директива.

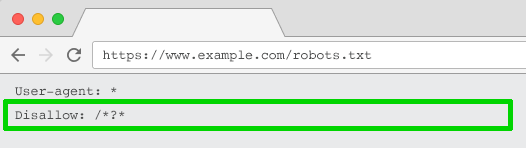

Robots.txt запретить

Изображение, созданное автором

Файл robots.txt – это то, на что поисковые системы сначала смотрят перед сканированием вашего сайта. Если они увидят, что что-то запрещено, они даже не пойдут туда.

Вы можете использовать этот файл для блокировки доступа сканера к каждому URL-адресу на основе параметров (с запретом: /*?*) или только к определенным строкам запроса, которые вы не хотите индексировать.

<сильный>Плюсы:

- Простая техническая реализация.

- Позволяет более эффективное сканирование.

- Избегает проблем с дублированием содержимого.

- Подходит для всех типов параметров, которые вы не хотите сканировать.

<сильный>Минусы:

- Не консолидирует рейтинговые сигналы.

- Не’не удаляет существующие URL-адреса из индекса.

Переход от динамических к статическим URL

Многие люди считают, что оптимальный способ обработки параметров URL-адреса — это просто избегать их.

В конце концов, вложенные папки превосходят параметры, чтобы помочь Google понять структуру сайта, а статические URL-адреса на основе ключевых слов всегда были краеугольным камнем поисковой оптимизации страниц.

Чтобы достичь этого, вы можете использовать перезапись URL-адресов на стороне сервера, чтобы преобразовать параметры в URL-адреса вложенных папок.

Например, URL:

www.example.com/view-product?id=482794

Будет:

www.example.com/widgets/purple

Этот подход хорошо работает для описательных параметров на основе ключевых слов, таких как определяющие категории, продукты или фильтры для атрибутов, релевантных поисковой системе. Он также эффективен для переведенного содержимого.

Но это становится проблематичным для нерелевантных ключевых слов элементов фасетной навигации, таких как точная цена. Наличие такого фильтра, как статический, индексированный URL-адрес, не дает значение SEO.

Это также проблема для параметров поиска, поскольку каждый созданный пользователем запрос создаст статическую страницу, которая будет соревноваться за рейтинг против канонической – или еще хуже, показывает сканерам страницы низкого качества, когда пользователь ищет товар, который вы не предлагаете.

Это несколько странно в применении к разбивке страниц (хотя это нередко через WordPress), что даст URL-адрес вроде

www.example.com/widgets/purple/page2

Очень странно для изменения порядка, что даст URL-адрес

www.example.com/widgets/purple/lowest-price

И часто это неподходящий вариант для отслеживания. Google Analytics не признает статическую версию параметра UTM.

Более того: замена динамических параметров статическими URL-адресами для таких вещей, как разбиение на страницы, результаты в окне поиска на сайте или сортировка, не влияет на повторяющееся содержимое, бюджет сканирования или уменьшение капитала внутренних ссылок.

Наличие всех комбинаций фильтров из вашей фасетной навигации как индексированных URL часто приводит к проблемам со слабым содержимым. Особенно, если вы предлагаете фильтры с несколькими выборами.

Многие профессионалы SEO утверждают, что можно обеспечить такое же взаимодействие с пользователем, не влияя на URL-адрес. К примеру, используя запросы POST вместо GET для изменения содержимого страницы. Таким образом, сохраняя взаимодействие с пользователем и избегая проблем с SEO.

Но удаление параметров таким образом лишит вашей аудитории возможности делать закладки или делиться ссылкой на эту конкретную страницу – и, очевидно, невозможен для отслеживания параметров и не является оптимальным для разбиения на страницы.

Суть проблемы состоит в том, что для многих веб-сайтов полностью избежать параметров просто невозможно, если вы хотите обеспечить идеальное взаимодействие с пользователем. Это также не будет лучшей практикой SEO.

Итак мы остались с этим. Для параметров, которые вы не хотите индексировать в результатах поиска (разбивка на страницы, изменение порядка, отслеживание и т.д.), реализуйте их как строки запроса. Для параметров, которые вы хотите проиндексировать, используйте статические URL-пути.

<сильный>Плюсы:

- Смещает фокус сканера с параметров на статические URL-адреса, которые имеют более высокую вероятность ранжирования.

<сильный>Минусы:

- Значительные затраты времени на разработку для перезаписи URL-адресов и перенаправления 301.

- Не’не предотвращает проблемы дублирования содержимого.

- Не консолидирует рейтинговые сигналы.

- Не подходит для всех типов параметров.

- Может вызвать проблемы со слабым содержанием.

- Не’всегда предоставляет URL, который можно посылать или закладывать.

Лучшие методы работы с параметрами URL для SEO

Поэтому какую из этих шести тактик SEO вы должны применить?

Ответом не могут быть все.

Это не только создаст ненужную сложность, но часто решения для SEO активно конфликтуют друг с другом.

Например, если вы применяете запрет robots.txt, Google не сможет увидеть никаких метатегов noindex. Вы также не должны сочетать метатег noindex с атрибутом rel=canonical link.

<~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~ В эпизоде Search Off The Record они обсудили проблемы, которые создают параметры для сканирования.

Они даже предлагают вернуть инструмент обработки параметров в Google Search Console. Google, если вы читаете это, пожалуйста, верните это назад!

Становится понятным то, что идеального решения не существует. Бывают случаи, когда эффективность сканирования важнее, чем консолидация сигналов авторитета.

В конце концов, то, что правильно для вашего веб-сайта, будет зависеть от ваших приоритетов.

Изображение, созданное автором

Лично я придерживаюсь следующего плана атаки для удобной обработки параметров для SEO:

- Исследуйте намерения пользователей, чтобы понять, какие параметры должны быть удобными для поисковых систем статическими URL-адресами.

- Ввести эффективную обработку разбивки страниц с помощью параметра ?page=.

- Для всех остальных URL-адресов на основе параметров заблокируйте сканирование с помощью запрета в файле robots.txt и добавьте тег noindex в качестве резервной копии.

- Дважды проверьте, не отправлен ли URL-адрес на основе параметров в XML-карте сайта.

Независимо от того, какую стратегию обработки параметров вы выберете, обязательно задокументируйте влияние ваших усилий на KPI.